প্রকাশিত: ১৩ জানুয়ারী, ২০২৫

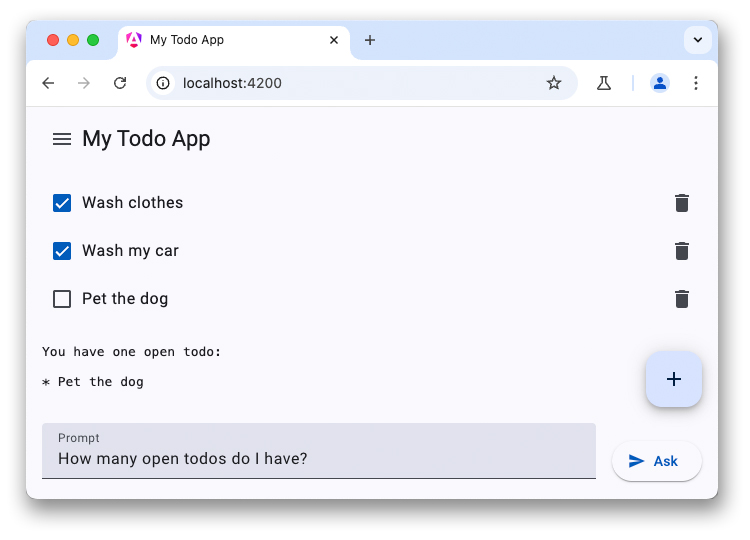

এটি LLM চ্যাটবট সম্পর্কিত তিন পর্বের সিরিজের শেষ। পূর্ববর্তী নিবন্ধগুলিতে ক্লায়েন্ট-সাইড LLM-এর শক্তি নিয়ে আলোচনা করা হয়েছে এবং একটি করণীয় তালিকা অ্যাপ্লিকেশনে একটি WebLLM-চালিত চ্যাটবট যুক্ত করার পদ্ধতি সম্পর্কে আলোচনা করা হয়েছে।

কিছু নতুন ডিভাইসে বৃহৎ ভাষা এবং অন্যান্য AI মডেল সরাসরি ডিভাইসে পাওয়া যায়। Chrome ব্রাউজারে অন্তর্নির্মিত AI API গুলিকে একীভূত করার প্রস্তাব করেছে, যার মধ্যে বেশ কয়েকটি API উন্নয়নের বিভিন্ন পর্যায়ে রয়েছে। এই API গুলির মধ্যে অনেকগুলি স্ট্যান্ডার্ড প্রক্রিয়ার মধ্য দিয়ে যাচ্ছে, যাতে ওয়েবসাইটগুলি সর্বোচ্চ অনুমান কর্মক্ষমতা অর্জনের জন্য একই বাস্তবায়ন এবং মডেল ব্যবহার করতে পারে।

প্রম্পট এপিআই হলো এরকমই একটি এআই এপিআই। এটি ব্যবহার করার জন্য, ডেভেলপারদের আর্লি প্রিভিউ প্রোগ্রামে সাইন আপ করতে উৎসাহিত করা হচ্ছে। একবার গৃহীত হলে, আপনি ব্রাউজারে প্রম্পট এপিআই কীভাবে সক্ষম করবেন সে সম্পর্কে নির্দেশাবলী পাবেন। প্রম্পট এপিআইটি ক্রোম এক্সটেনশনের জন্য একটি অরিজিন ট্রায়ালে উপলব্ধ, তাই আপনি প্রকৃত এক্সটেনশন ব্যবহারকারীদের জন্য এই এপিআই পরীক্ষা করতে পারেন।

শেয়ার্ড মডেল অ্যাক্সেস

প্রম্পট এপিআই ওয়েবএলএলএম-এর মতোই আচরণ করে। তবে, এবার কোনও মডেল নির্বাচন নেই (আপনাকে ব্রাউজারের সাথে পাঠানো LLM ব্যবহার করতে হবে)। বিল্ট-ইন এআই সক্ষম করার সময়, ক্রোম ব্রাউজারে জেমিনি ন্যানো ডাউনলোড করে। এই মডেলটি একাধিক অরিজিনে শেয়ার করা যেতে পারে এবং সর্বোচ্চ কর্মক্ষমতা সহ চালানো যেতে পারে। একটি গিটহাব সমস্যা রয়েছে যেখানে একজন ডেভেলপার একটি মডেল নির্বাচন বৈশিষ্ট্য যোগ করার অনুরোধ করেছেন।

কথোপকথন সেট আপ করুন

আপনি ঠিক একইভাবে বার্তা কথোপকথন শুরু করতে পারেন, তবে Prompt API সিস্টেম প্রম্পট নির্দিষ্ট করার জন্য একটি শর্টহ্যান্ড সিনট্যাক্সও অফার করে। LanguageModel ইন্টারফেসে create() পদ্ধতি ব্যবহার করে ভাষা মডেল সেশন শুরু করুন:

const session = await LanguageModel.create({

initialPrompt: [

{

type: 'system',

content: `You are a helpful assistant. You will answer questions related

to the user's to-do list. Decline all other requests not related to the

user's todos. This is the to-do list in JSON: ${JSON.stringify(todos)}`,

},

],

});

তোমার প্রথম প্রশ্নের উত্তর দাও

স্ট্রিমিং কনফিগার করার জন্য একটি কনফিগারেশন অবজেক্ট থাকার পরিবর্তে, প্রম্পট API দুটি পৃথক পদ্ধতি অফার করে:

-

prompt()সম্পূর্ণ স্ট্রিং ফেরত দেয় -

promptStreaming()একটি অ্যাসিঙ্ক ইটারেবল ফেরত দেয়। WebLLM এর বিপরীতে, Prompt API সম্পূর্ণ স্ট্রিং রেসপন্সের সাথে সাড়া দেয়, তাই আপনাকে নিজেরাই ফলাফল একত্রিত করতে হবে না।

যদি অন্য কোনও অরিজিন আগে মডেল ডাউনলোড শুরু না করে থাকে, তাহলে আপনার ব্রাউজারে জেমিনি ন্যানো ডাউনলোড করার সময় আপনার প্রথম অনুরোধে অনেক সময় লাগতে পারে। যদি মডেলটি ইতিমধ্যেই উপলব্ধ থাকে, তাহলে অনুমান অবিলম্বে শুরু হয়।

const stream = session.promptStreaming("How many open todos do I have?");

for await (const reply of stream) {

console.log(reply);

}

ডেমো

সারাংশ

অ্যাপ্লিকেশনগুলিতে LLM গুলিকে একীভূত করলে ব্যবহারকারীর অভিজ্ঞতা উল্লেখযোগ্যভাবে বৃদ্ধি পেতে পারে। যদিও ক্লাউড পরিষেবাগুলি ব্যবহারকারীর ডিভাইস নির্বিশেষে উচ্চমানের মডেল এবং উচ্চ অনুমান কর্মক্ষমতা প্রদান করে, WebLLM এবং Chrome এর প্রম্পট API-এর মতো অন-ডিভাইস সমাধানগুলি অফলাইনে সক্ষম, গোপনীয়তা উন্নত করে এবং ক্লাউড-ভিত্তিক বিকল্পগুলির তুলনায় খরচ সাশ্রয় করে। এই নতুন APIগুলি ব্যবহার করে দেখুন এবং আপনার ওয়েব অ্যাপ্লিকেশনগুলিকে আরও স্মার্ট করুন।