Publicado el 10 de noviembre de 2025

Una vez que hayas leído sobre la IA del tamaño adecuado, sabrás que los modelos más pequeños son más sostenibles que los modelos de base. Consumen menos energía y hasta se pueden ejecutar en el dispositivo del usuario, lo que reduce la latencia y proporciona una experiencia más eficiente.

Debes ser intencional y elegir el modelo adecuado para tu caso de uso.

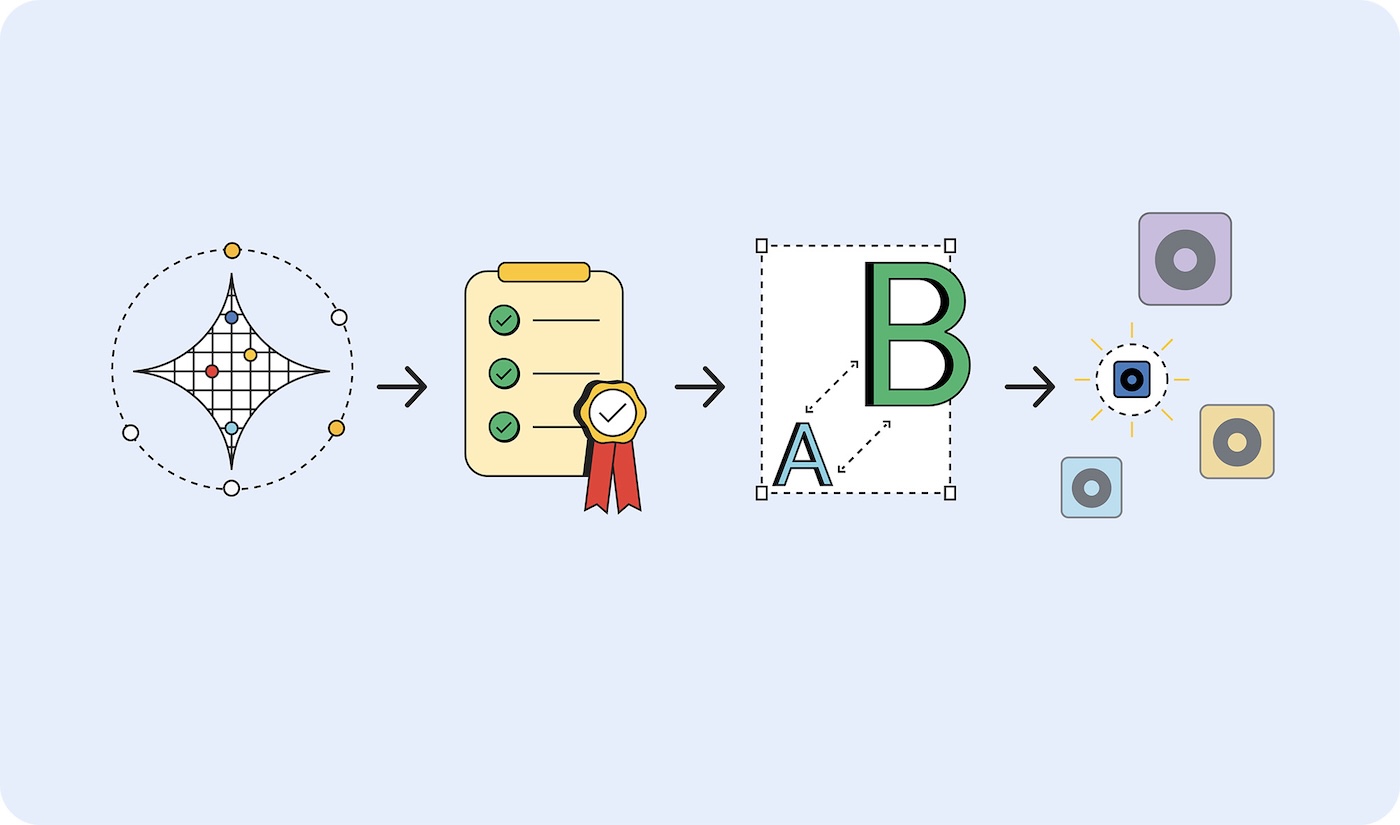

Pero, ¿cómo determinas qué modelo necesitas? Un enfoque es determinar las métricas de éxito de tu aplicación y, luego, crear un prototipo con un modelo fundamental. Si bien, recientemente, muchos de los modelos de base que se mencionan en las noticias son modelos de lenguaje grandes (LLM), los modelos de base también incluyen la IA predictiva, que es especializada y puede adaptarse mejor a tu caso de uso.

Una vez que valides las métricas de éxito, realiza la implementación con modelos más pequeños y haz pruebas hasta que encuentres el modelo más pequeño posible que produzca resultados que cumplan con tus criterios de éxito.

Crea prototipos grandes y lanza versiones pequeñas

Para elegir el modelo adecuado, sigue estos pasos:

- Demuestra que tu tarea es posible. Prueba si lo que intentas lograr es posible con el modelo más grande posible. Puede ser un modelo de lenguaje grande, como Gemini 2.5 Pro, o bien otro modelo de base.

- Establece criterios de éxito. Recopila un conjunto de entradas y salidas ideales. Por ejemplo, una aplicación de traducción puede tener entradas de frases en inglés y salidas de esas frases traducidas correctamente al español.

- Realiza pruebas de pequeño a grande. Compara los resultados de los modelos más pequeños con tus criterios de prueba. Comienza con el modelo más pequeño y avanza hasta el más grande. La ingeniería de instrucciones puede ayudarte a obtener mejores resultados. También puedes recurrir a un modelo más grande para comparar los resultados y obtener un mejor resultado de tu modelo más pequeño.

- Selecciona el modelo más pequeño que proporcione respuestas aceptables para tu caso de uso. Por ejemplo, el modelo más pequeño que genera traducciones correctamente.

Independientemente de dónde se aloje el modelo, si es lo suficientemente pequeño como para estar en el dispositivo o si aún necesita alojarse en un servidor, es más eficiente usar un modelo más pequeño que uno más grande.

Tipos de modelos

Categoricé los modelos según los datos que procesan: visuales, de audio y de texto. Te mostraré ejemplos de casos de uso y algunos de los modelos disponibles.

Procesamiento visual

El procesamiento visual puede ser la evaluación de imágenes estáticas o videos.

Clasificación de imágenes: Se usa para todo, desde la generación de texto alternativo para el cumplimiento de la accesibilidad hasta la revisión de contenido para filtrar imágenes inapropiadas antes de que lleguen a los usuarios. Elige esta clasificación de imágenes cuando necesites comprender el contenido de una imagen sin una revisión humana.

Modelos MobileNet, ResNeXt y ConvNeXt

Detección de objetos: Etiqueta objetos específicos en imágenes o transmisiones de video, crea experiencias interactivas de RA que responden a objetos del mundo real o crea sistemas de administración de inventario que pueden identificar y contar elementos. Elige la detección de objetos cuando tengas una foto o un video de un objeto inanimado.

Modelos: Modelos de detección de objetos, como YOLOv8 y DETR

Detección de la postura corporal: Se usa para controlar la interfaz con gestos o movimientos corporales, experiencias de prueba virtual de ropa y plataformas de telemedicina que supervisan el movimiento del paciente y el progreso de la rehabilitación. Elige la detección de la postura corporal cuando evalúes imágenes o videos del cuerpo de una persona.

Modelos de estimación de poses, como MoveNet y BlazePose

Detección de puntos clave faciales: Se usa para sistemas de autenticación facial seguros, detección de emociones para personalizar las experiencias del usuario, seguimiento del movimiento ocular para controles accesibles y filtros de fotos o aplicaciones de belleza en tiempo real. Elige este modelo cuando evalúes imágenes o videos del rostro de una persona.

Modelos MediaPipe FaceMesh y OpenPose

Modelos de detección de poses de manos: Usa estos modelos para controles de interfaz sin contacto en los que los usuarios navegan con gestos de manos, aplicaciones de traducción de lenguaje de señas para la accesibilidad y herramientas creativas que responden a los movimientos de las manos para dibujar o diseñar. También considera usar estos controles en entornos en los que tocar las pantallas no es práctico (servicios médicos o de alimentos) o cuando los usuarios estarán lejos de los controles, como en presentaciones en las que los oradores controlan las diapositivas con gestos.

Modelos: Modelos de estimación de la pose de la mano, como MediaPipe Hands.

Reconocimiento de escritura a mano: Se usa para convertir notas escritas a mano en texto digital con capacidad de búsqueda, procesar la entrada de lápiz para aplicaciones de toma de notas y digitalizar formularios o documentos subidos por los usuarios.

Modelos de reconocimiento óptico de caracteres (OCR), como MiniCPM-o, H2OVL-Mississippi y Surya.

Modelos de segmentación de imágenes: Elige esta opción cuando los fondos de imágenes coherentes sean importantes o se requiera la edición de imágenes. Por ejemplo, podrías usarlos para quitar el fondo con precisión, realizar una revisión avanzada del contenido para identificar áreas específicas de preocupación en las imágenes y usar herramientas sofisticadas de edición de fotos para aislar elementos particulares, como fotos de perfil y de productos.

Modelos Segment Anything (SAM), Mask R-CNN

Generación de imágenes: Se usa para crear imágenes nuevas a pedido, sin licencia. Estos modelos se podrían usar para crear avatares personalizados para perfiles de usuario, variaciones de imágenes de productos para catálogos de comercio electrónico y recursos visuales personalizados para flujos de trabajo de marketing o creación de contenido.

Modelos: Modelos de difusión, como Nano Banana, Flux y Qwen Image

Procesamiento de audio

Elige un modelo de procesamiento de audio para los archivos de audio.

Clasificación de audio: Se usa cuando es necesario identificar y describir el audio, sin revisión humana. Por ejemplo, la identificación en tiempo real de música de fondo, sonidos ambientales o contenido hablado en cargas de medios, el etiquetado automático de contenido para bibliotecas de audio y los controles de interfaz de usuario basados en sonido.

Modelos Wav2Vec2 y AudioMAE

Generación de audio: Crea contenido de audio a pedido sin necesidad de licencias. Por ejemplo, se puede usar para crear efectos de sonido personalizados para experiencias web interactivas, generar música de fondo a partir de las preferencias o el contenido del usuario, y producir elementos de marca de audio, como sonidos de notificación o comentarios de la interfaz.

Modelos: Existen varios modelos especializados de generación de audio. Estos suelen ser muy específicos, por lo que no enumeraré los modelos.

Texto a voz (TTS): Convierte contenido escrito en voz coherente y con sonido natural para cumplir con los requisitos de accesibilidad, crear narraciones de voz en off para contenido educativo o instructivos, y compilar interfaces multilingües que hablen texto en los idiomas preferidos de los usuarios.

Modelos de CSM de Orpheus y Sesame

Voz a texto (STT): Transcribe una grabación de voz humana, por ejemplo, para la transcripción en tiempo real de eventos o reuniones en vivo, la navegación controlada por voz y la función de búsqueda, y el subtitulado automático para la accesibilidad del contenido de video.

Modelos Whisper Web Turbo, NVIDIA Canary y Kyutai

Procesamiento de texto

Clasificación de lenguaje natural (PLN): Se usa para ordenar y enrutar automáticamente grandes cantidades de texto, sistemas de etiquetado y sistemas de moderación. El texto podría ser mensajes de usuarios o tickets de asistencia, detectar el sentimiento en los comentarios de los clientes o las menciones en redes sociales, y filtrar el spam o el contenido inapropiado antes de que llegue a otros usuarios.

Modelos BERT, DistilBERT y RoBERTa

IA conversacional: Crea interfaces de chat y sistemas conversacionales. Los chatbots de asistencia al cliente, los asistentes personales basados en IA y las interacciones conversacionales similares son algunos de los mejores casos de uso para los LLM. Afortunadamente, existen modelos de lenguaje lo suficientemente pequeños como para caber en tu dispositivo, que requieren mucha menos energía para entrenar y generar instrucciones.

Modelos Gemma 2 27B, Llama 3.1 y Qwen2.5

Modelos de traducción: Se usan para admitir varios idiomas en tu aplicación. Los modelos de lenguaje locales pueden controlar la traducción de idiomas en tiempo real, convertir el contenido generado por los usuarios en varios idiomas para las plataformas globales y permitir la traducción privada de documentos que mantiene el contenido sensible en el dispositivo del usuario.

Modelos de SLM, como Gemma Nano, Granite 1.5B, GSmolLM3 y Qwen 3.4B

Lee la etiqueta de información nutricional

Los diferentes modelos consumen cantidades variables de estos recursos cuando se ejecutan en diferentes ubicaciones y hardware. Aún no existe un estándar de medición para realizar comparaciones, pero hay un movimiento para incluir esta información en las "etiquetas de banda ancha" de la IA.

Las tarjetas de modelo, presentadas por Margaret Mitchell y sus colegas de Google en 2018, son un enfoque estandarizado para informar el uso previsto, las limitaciones, las consideraciones éticas y el rendimiento de los modelos. Actualmente, muchas empresas utilizan una forma de tarjetas de modelo, incluidas Hugging Face, Meta y Microsoft.

Las hojas informativas de IA de IBM, que abarcan el ciclo de vida, la responsabilidad, la gobernanza y el cumplimiento, son más populares en los entornos empresariales. Los marcos regulatorios, como la Ley sobre la IA de la UE, el Marco de Gestión de Riesgos de la IA del NIST y la norma ISO 42001, exigen esta documentación.

Google solicitó transparencia en los costos de inferencia en toda la industria. Estas cifras se podrían agregar a las tarjetas de modelos y a las hojas informativas. Hugging Face agregó costos de carbono a sus tarjetas de modelos y se esforzó por estandarizar la medición de la eficiencia energética con la iniciativa AI Energy Score.

Promueve la IA del tamaño adecuado

La IA adecuada es la opción sostenible, pragmática y de alto rendimiento para tus clientes y tu empresa.

Puedes impulsar la industria exigiendo que los modelos alojados que adopte tu empresa divulguen sus requisitos de recursos de inferencia y entrenamiento de referencia. Si suficientes clientes exigen transparencia, es más probable que los proveedores divulguen esos detalles.