Data di pubblicazione: 10 novembre 2025

Dopo aver letto informazioni sull'AI dimensionata correttamente, sai che i modelli più piccoli sono più sostenibili di quelli di base. Consumano meno energia e possono essere eseguiti anche sul dispositivo dell'utente, riducendo la latenza e offrendo un'esperienza più performante.

Devi essere intenzionale e scegliere il modello giusto per il tuo caso d'uso.

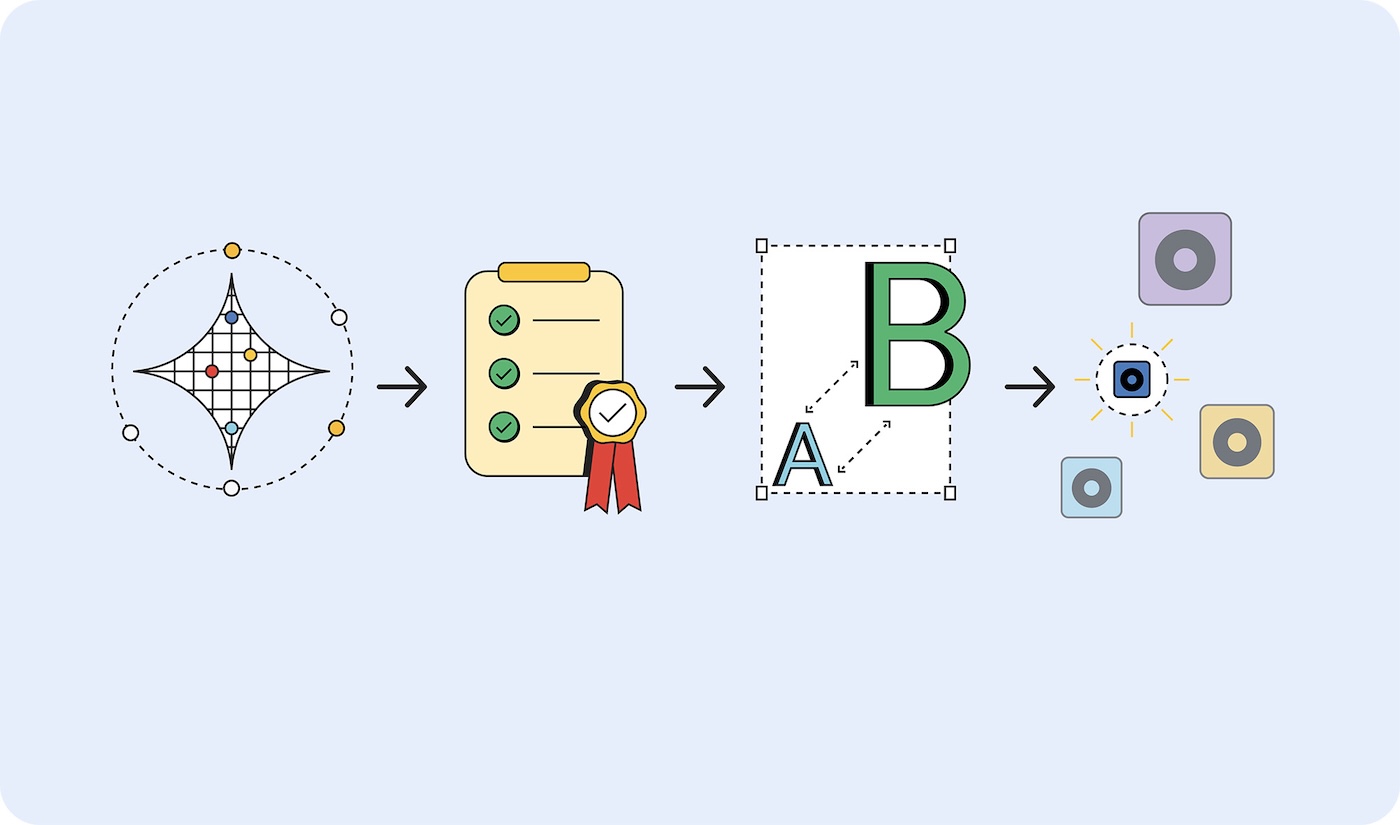

Ma come fai a determinare il modello di cui hai bisogno? Un approccio consiste nel determinare le metriche di successo per la tua applicazione, quindi creare un prototipo con un modello di base. Sebbene di recente molti dei modelli di base citati nelle notizie siano modelli linguistici di grandi dimensioni (LLM), i modelli di base includono anche l'AI predittiva, che è specializzata e potrebbe essere più adatta al tuo caso d'uso.

Una volta convalidate le metriche di successo, esegui il deployment con modelli più piccoli e testa finché non trovi il modello più piccolo possibile che produca risultati che soddisfino i tuoi criteri di successo.

Prototipa in grande, esegui il deployment in piccolo

Per scegliere il modello più adatto alle tue esigenze, segui questi passaggi:

- Dimostra che la tua attività è possibile. Verifica se ciò che stai cercando di ottenere è possibile utilizzando il modello più grande possibile. Potrebbe trattarsi di un modello linguistico di grandi dimensioni, come Gemini 2.5 Pro, o di un altro modello di base.

- Definisci i criteri di successo. Raccogli un insieme di input e output ideali. Ad esempio, un'applicazione di traduzione può avere input di frasi in inglese e output di queste frasi tradotte correttamente in spagnolo.

- Esegui test da piccoli a grandi. Confronta gli output dei modelli più piccoli con i tuoi criteri di test. Inizia dal modello più piccolo. Il prompt engineering può aiutarti a ottenere risultati migliori. Puoi anche reclutare un modello più grande per confrontare gli output, per aiutarti a produrre un risultato migliore dal modello più piccolo.

- Seleziona il modello più piccolo che fornisce risposte accettabili per il tuo caso d'uso. Ad esempio, il modello più piccolo che restituisce le traduzioni correttamente.

Indipendentemente da dove è ospitato il modello, se è abbastanza piccolo da essere sul dispositivo o deve ancora essere ospitato su un server, è più efficiente utilizzare un modello più piccolo rispetto a un modello più grande.

Tipi di modello

Ho classificato i modelli in base ai dati che elaborano: visivi, audio e testo. Ti mostrerò alcuni casi d'uso di esempio e alcuni dei modelli disponibili.

Elaborazione visiva

L'elaborazione visiva può essere la valutazione di immagini statiche o video.

Classificazione delle immagini: utilizzala per qualsiasi attività, dalla generazione di testo alternativo per la conformità all'accessibilità al controllo dei contenuti per filtrare le immagini inappropriate prima che raggiungano gli utenti. Scegli questa classificazione delle immagini quando devi capire cosa c'è in un'immagine, senza una revisione umana.

Modelli MobileNet, ResNeXt e ConvNeXt

Rilevamento di oggetti: tagga oggetti specifici in immagini o flussi video, crea esperienze AR interattive che rispondono a oggetti del mondo reale o crea sistemi di gestione dell'inventario in grado di identificare e contare gli articoli. Scegli il rilevamento di oggetti quando hai una foto o un video di un oggetto inanimato.

Modelli Modelli di rilevamento degli oggetti, ad esempio YOLOv8 e DETR

Rilevamento della postura: utilizza questa funzionalità per il controllo dell'interfaccia con gesti o movimenti del corpo, esperienze di prova virtuale di abiti e piattaforme di telemedicina che monitorano i movimenti dei pazienti e i progressi della riabilitazione. Scegli il rilevamento della postura del corpo quando valuti immagini o video del corpo di una persona.

Modelli: modelli di stima della posa, come MoveNet e BlazePose

Rilevamento dei punti chiave del volto: utilizzato per sistemi di autenticazione facciale sicuri, rilevamento delle emozioni per personalizzare le esperienze utente, monitoraggio del movimento degli occhi per controlli accessibili e filtri fotografici o applicazioni di bellezza in tempo reale. Scegli questo modello quando valuti immagini o video del volto di una persona.

Modelli MediaPipe FaceMesh e OpenPose

Modelli di rilevamento della postura della mano: utilizza questi modelli per i controlli dell'interfaccia senza contatto in cui gli utenti navigano con i gesti delle mani, le applicazioni di traduzione della lingua dei segni per l'accessibilità e gli strumenti creativi che rispondono ai movimenti delle mani per disegnare o progettare. Inoltre, valuta la possibilità di utilizzarli in ambienti in cui toccare gli schermi non è pratico (settore medico, ristorazione) o quando gli utenti si trovano lontano dai controlli, ad esempio durante le presentazioni in cui gli oratori controllano le slide con i gesti.

Modelli Modelli di stima della postura della mano, come MediaPipe Hands.

Riconoscimento della scrittura: utilizzalo per convertire le note scritte a mano in testo digitale ricercabile, elaborare l'input dello stilo per le applicazioni di annotazione e digitalizzare moduli o documenti caricati dagli utenti.

Modelli Modelli di riconoscimento ottico dei caratteri (OCR), come MiniCPM-o, H2OVL-Mississippi e Surya.

Modelli di segmentazione delle immagini: scegli quando sono importanti sfondi delle immagini coerenti o è necessaria la modifica delle immagini. Ad esempio, potresti utilizzarli per rimuovere lo sfondo con precisione, eseguire uno screening avanzato dei contenuti per identificare aree specifiche di interesse all'interno delle immagini e utilizzare strumenti di fotoritocco sofisticati per isolare elementi particolari, come le foto del profilo e dei prodotti.

Modelli Segment Anything (SAM), Mask R-CNN

Generazione di immagini: utilizzala per creare nuove immagini on demand, senza licenze. Questi modelli potrebbero essere utilizzati per creare avatar personalizzati per i profili utente, variazioni delle immagini dei prodotti per i cataloghi di e-commerce e immagini personalizzate per i workflow di marketing o di creazione di contenuti.

Modelli: modelli di diffusione, come Nano Banana, Flux e Qwen Image

Elaborazione audio

Scegli un modello di elaborazione dell'audio per i file audio.

Classificazione audio: utilizza questa opzione quando l'audio deve essere identificato e descritto, senza revisione umana. Ad esempio, l'identificazione in tempo reale di musica di sottofondo, suoni ambientali o contenuti parlati negli upload multimediali, il tagging automatico dei contenuti per le librerie audio e i controlli dell'interfaccia utente basati sul suono.

Modelli Wav2Vec2 e AudioMAE

Generazione audio: crea contenuti audio on demand senza licenza. Ad esempio, può essere utilizzato per creare effetti sonori personalizzati per esperienze web interattive, generare musica di sottofondo dalle preferenze o dai contenuti dell'utente e produrre elementi di branding audio come suoni di notifica o feedback dell'interfaccia.

Modelli: esistono vari modelli specializzati per la generazione di audio. Questi tendono a essere molto specifici, quindi non elencherò i modelli.

Sintesi vocale (TTS): converte i contenuti scritti in un parlato coerente e dal suono naturale per la conformità all'accessibilità, creando la voce fuori campo per i contenuti didattici o i tutorial e creando interfacce multilingue che riproducono il testo nelle lingue preferite dagli utenti.

Modelli Orpheus e Sesame CSM

Speech-to-text (STT): trascrivi una registrazione del parlato umano, ad esempio per la trascrizione in tempo reale per eventi o riunioni dal vivo, la navigazione e la funzionalità di ricerca controllate con la voce e i sottotitoli codificati automatici per l'accessibilità dei contenuti video.

Modelli Whisper Web Turbo, NVIDIA Canary e Kyutai

Elaborazione del testo

Classificazione del linguaggio naturale (NLP): utilizzala per ordinare e indirizzare automaticamente grandi quantità di testo, sistemi di tagging e sistemi di moderazione. Il testo potrebbe essere messaggi degli utenti o richieste di assistenza, rilevare il sentiment nei feedback dei clienti o nelle menzioni sui social media e filtrare spam o contenuti inappropriati prima che raggiungano altri utenti.

Modelli BERT, DistilBERT e RoBERTa

AI conversazionale: crea interfacce di chat e sistemi di conversazione. I chatbot di assistenza clienti, gli assistenti AI personali e interazioni conversazionali simili sono alcuni dei migliori casi d'uso per i modelli LLM. Fortunatamente, esistono modelli linguistici abbastanza piccoli da essere memorizzati sul dispositivo, che richiedono molta meno energia per l'addestramento e il prompt.

Modelli Gemma 2 27B, Llama 3.1 e Qwen2.5

Modelli di traduzione: utilizzali per supportare più lingue nella tua applicazione. I modelli linguistici locali possono gestire la traduzione linguistica in tempo reale, convertendo i contenuti generati dagli utenti in più lingue per le piattaforme globali e consentendo la traduzione privata dei documenti che mantiene i contenuti sensibili sul dispositivo dell'utente.

Modelli SLM come Gemma Nano, Granite 1.5B, GSmolLM3 e Qwen 3.4B

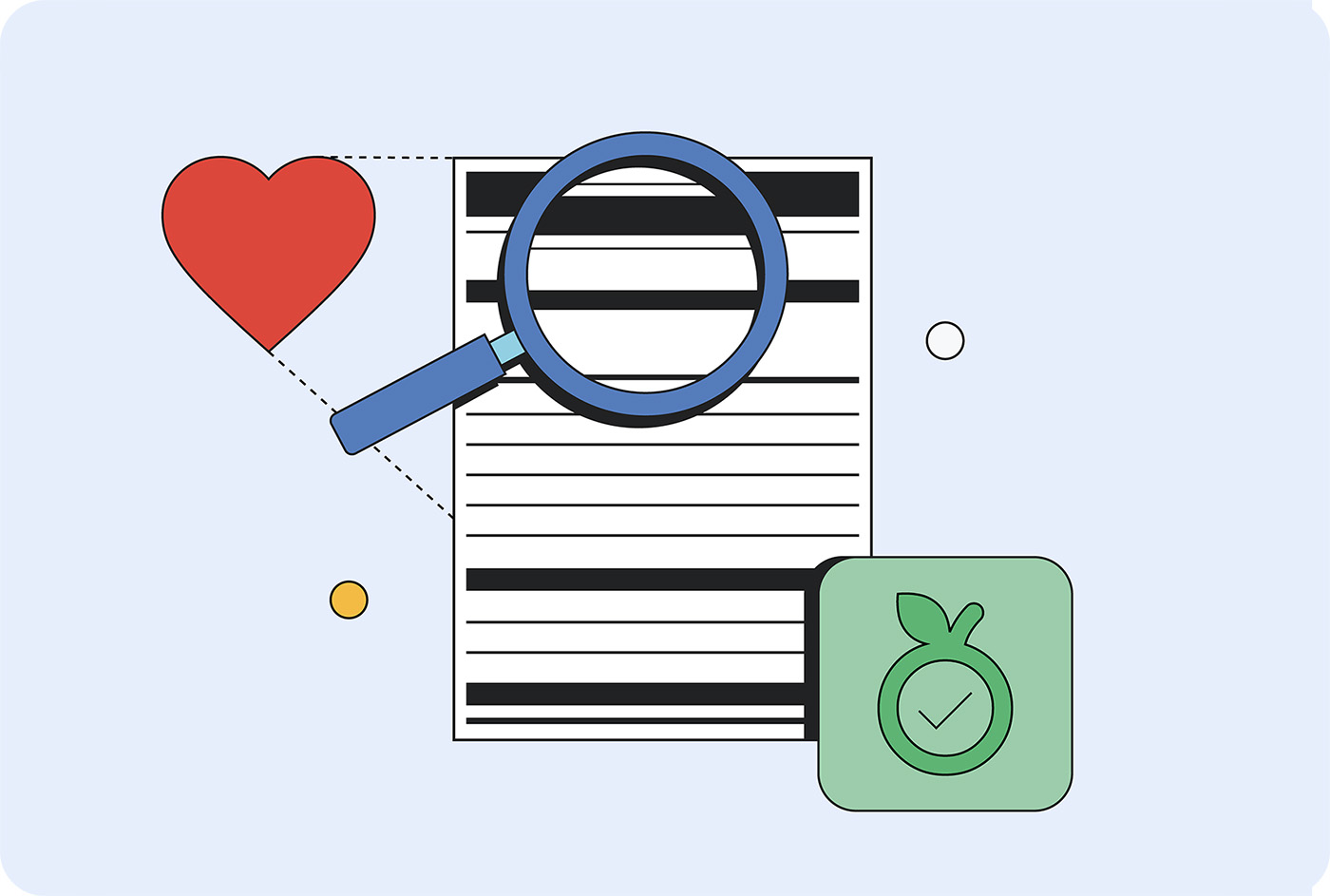

Leggere l'etichetta nutrizionale

Modelli diversi consumano quantità variabili di queste risorse quando vengono eseguiti su hardware diversi in posizioni diverse. Non esiste ancora uno standard di misurazione con cui confrontarsi, ma si sta lavorando per inserire queste informazioni nelle "etichette nutrizionali " dell'AI.

Le schede del modello, introdotte da Margaret Mitchell e dai suoi colleghi di Google nel 2018, sono un approccio standardizzato per segnalare l'uso previsto, le limitazioni, le considerazioni etiche e le prestazioni dei modelli. Oggi molte aziende utilizzano una forma di schede del modello, tra cui Hugging Face, Meta e Microsoft.

AI Factsheets di IBM, che coprono ciclo di vita, responsabilità, governance e conformità, sono più popolari negli ambienti aziendali. I quadri normativi, come l'AI Act dell'UE, l'AI Risk Management Framework del NIST e lo standard ISO 42001, richiedono questa documentazione.

Google ha chiesto la trasparenza dei costi di inferenza in tutto il settore. Questi dati potrebbero essere aggiunti alle schede e ai prospetti dei modelli. Hugging Face ha aggiunto i costi di emissioni di carbonio alle schede dei modelli e si è impegnata a standardizzare la misurazione dell'efficienza energetica con l'iniziativa AI Energy Score.

Promuovere l'AI delle dimensioni giuste

L'AI dimensionata correttamente è la scelta sostenibile, performante e pragmatica per i tuoi clienti e per la tua attività.

Puoi far progredire il settore richiedendo che i modelli ospitati adottati dalla tua azienda rivelino i requisiti di risorse di addestramento e inferenza di base. Se un numero sufficiente di clienti richiede trasparenza, è più probabile che i fornitori pubblichino questi dettagli.