Veröffentlicht: 21. Mai 2025

Policybazaar ist eine der führenden Versicherungsplattformen in Indien mit über 97 Millionen registrierten Kunden. Etwa 80% der Kunden besuchen Policybazaar jeden Monat online. Daher ist es wichtig, dass die Plattformen eine reibungslose Nutzererfahrung bieten.

Das Team von Policybazaar stellte fest, dass eine beträchtliche Anzahl von Nutzern die Website abends besuchte, also nach den Arbeitszeiten des Kundensupportteams. Anstatt dass Nutzer auf Antworten warten oder Mitarbeiter für die Nachtschicht einstellen mussten, wollte Policybazaar eine Lösung implementieren, mit der diese Nutzer sofort Hilfe erhalten.

Kunden haben viele Fragen zu Versicherungstarifen, wie sie funktionieren und welcher Tarif ihren Anforderungen entspricht. Personalisierte Fragen lassen sich mit FAQs oder regelbasierten Chatbots nur schwer beantworten. Um diese Anforderungen zu erfüllen, implementierte das Team personalisierte Unterstützung mit generativer KI.

73 %

Nutzer haben hochwertige Unterhaltungen gestartet und daran teilgenommen

2-mal

Höhere Klickrate im Vergleich zum vorherigen Call-to-Action

10x

Schnellere Inferenz mit WebGPU

Individuelle Unterstützung mit Finova-KI

Um personalisierte Antworten und eine bessere Kundenbetreuung auf Englisch und in der Muttersprache einiger Nutzer zu bieten, hat Policybazaar den KI-gestützten Chatbot „Finova AI“ entwickelt.

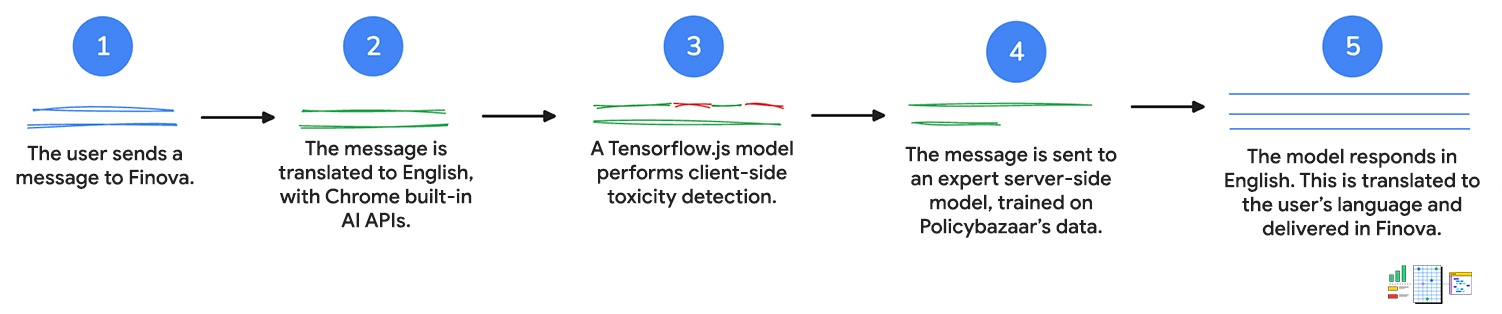

Es waren viele Schritte erforderlich, um dies zu ermöglichen. Eine detaillierte Schritt-für-Schritt-Anleitung finden Sie im Vortrag Web AI use cases and strategies in the real world (Anwendungsfälle und Strategien für Web-KI in der Praxis) von der Google I/O 2025.

1. Nutzereingabe

Zuerst sendet der Kunde eine Nachricht an den Chatbot, entweder per Text oder per Sprachbefehl. Wenn der Nutzer mit dem Chatbot spricht, wird die Web Speech API verwendet, um die Sprache in Text umzuwandeln.

2. Ins Deutsche übersetzen

Die Nachricht des Kunden wird an die Language Detector API gesendet. Wenn die API eine indische Sprache erkennt, wird die Eingabe zur Übersetzung ins Englische an die Translator API gesendet.

Bei beiden APIs erfolgt die Inferenz clientseitig. Das bedeutet, dass die Nutzereingabe während der Übersetzung nicht vom Gerät übertragen wird.

3. Nachricht wird mithilfe der Funktion zur Erkennung von unangemessenen Inhalten bewertet

Mit einem clientseitigen Modell zur Erkennung von schädlichen Inhalten wird festgestellt, ob die Eingabe des Kunden unangemessene oder aggressive Wörter enthält. In diesem Fall wird der Kunde aufgefordert, die Nachricht umzuformulieren. Wenn die Nachricht schädliche Sprache enthält, wird sie nicht an den nächsten Schritt weitergeleitet.

So können respektvolle Unterhaltungen geführt werden, die das Kundenserviceteam bei Bedarf überprüfen und weiterverfolgen kann.

4. Anfrage wird an den Server gesendet

Die übersetzte Suchanfrage wird dann an ein serverseitiges Modell übergeben, das mit den Daten von Policybazaar trainiert wurde. Dieses Modell gibt eine englischsprachige Antwort auf die Frage zurück.

Kunden erhalten personalisierte Antworten und Empfehlungen sowie Antworten auf komplexere Fragen zu Produkten.

5. In die Sprache des Kunden übersetzen

Die Translator API, die für die Übersetzung der ursprünglichen Suchanfrage verwendet wird, übersetzt die Suchanfrage zurück in die Sprache des Kunden, die von der Language Detector API erkannt wurde. Auch diese APIs werden clientseitig ausgeführt, sodass alle Vorgänge auf dem Gerät stattfinden. So erhalten Kunden Unterstützung in ihrer Muttersprache. Das macht den Chatbot auch für Nicht-Englischsprachige zugänglich.

Hybridarchitektur

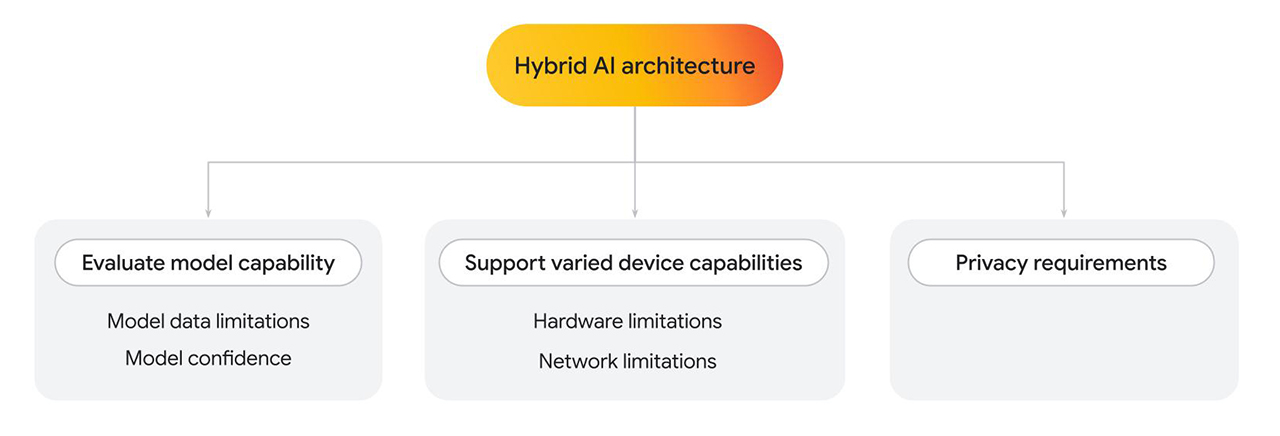

Finova AI, das sowohl auf Desktop- als auch auf Mobilplattformen ausgeführt wird, nutzt mehrere Modelle, um die Endergebnisse zu generieren. Policybazaar hat eine hybride Architektur entwickelt, bei der ein Teil der Lösung clientseitig und ein Teil serverseitig ausgeführt wird.

Es gibt eine Reihe von Gründen, warum Sie eine Hybridarchitektur implementieren sollten, unabhängig davon, ob Sie nur ein oder mehrere Modelle verwenden.

- Funktionen des clientseitigen Modells bewerten Bei Bedarf auf die serverseitige Verarbeitung zurückgreifen.

- Einschränkungen bei Modelldaten: Sprachmodelle können sehr unterschiedlich groß sein, was auch bestimmte Funktionen bestimmt. Angenommen, ein Nutzer stellt eine persönliche Frage zu einem von Ihnen angebotenen Dienst. Ein clientseitiges Modell kann die Frage möglicherweise beantworten, wenn es in diesem Bereich trainiert wurde. Falls dies nicht möglich ist, können Sie auf eine serverseitige Implementierung zurückgreifen, die mit einem komplexeren und größeren Dataset trainiert wurde.

- Modellvertrauen: Bei Klassifizierungsmodellen wie der Inhaltsmoderation oder Betrugserkennung kann ein clientseitiges Modell einen niedrigeren Konfidenzwert liefern. In diesem Fall sollten Sie auf ein leistungsstärkeres serverseitiges Modell zurückgreifen.

- Unterstützung verschiedener Gerätefunktionen

- Hardwareeinschränkungen: Idealerweise sollten KI-Funktionen für alle Nutzer zugänglich sein. In der Realität nutzen Nutzer eine Vielzahl von Geräten und nicht alle Geräte unterstützen KI-Inferenzen. Wenn ein Gerät keine clientseitige Inferenz unterstützt, können Sie auf den Server zurückgreifen. Mit diesem Ansatz können Sie Ihre Funktion barrierefrei gestalten und gleichzeitig Kosten und Latenz nach Möglichkeit minimieren.

- Netzwerkeinschränkungen: Wenn der Nutzer offline ist oder sich in einem fehlerhaften Netzwerk befindet, aber ein im Browser im Cache gespeichertes Modell hat, können Sie das Modell clientseitig ausführen.

- Datenschutzanforderungen

- Möglicherweise gelten für Ihre Anwendung strenge Datenschutzanforderungen. Wenn beispielsweise ein Teil des Nutzerflusses eine Identitätsbestätigung mit personenbezogenen Daten oder Gesichtserkennung erfordert, wählen Sie ein clientseitiges Modell aus, um Daten auf dem Gerät zu verarbeiten und die Bestätigungsausgabe (z. B. „Erfolgreich“ oder „Fehlgeschlagen“) für die nächsten Schritte an das serverseitige Modell zu senden.

Für Policybazaar, bei dem eine geringe Latenz, Kosteneffizienz und Datenschutz erforderlich waren, wurde eine clientseitige Lösung verwendet. Wenn komplexere Modelle erforderlich waren, die mit benutzerdefinierten Daten trainiert wurden, wurde eine serverseitige Lösung verwendet.

Hier sehen wir uns die clientseitige Modellimplementierung genauer an.

Clientseitige Erkennung schädlicher Inhalte

Nachdem die Nachrichten übersetzt wurden, wird die Nachricht des Kunden an das Modell zur Erkennung von schädlichen Inhalten von TensorFlow.js übergeben, das clientseitig auf Computern und Mobilgeräten ausgeführt wird. Da die Transkription zur weiteren Bearbeitung an Mitarbeiter der Kundenserviceabteilung weitergeleitet wird, ist es wichtig, vulgäre Sprache zu vermeiden. Die Nachrichten werden auf dem Gerät des Nutzers analysiert, bevor sie an den Server und dann an das zuständige Kundenservicemitarbeiter gesendet werden.

Außerdem konnten durch die clientseitige Analyse vertrauliche Daten entfernt werden. Der Datenschutz der Nutzer hat für uns oberste Priorität. Clientseitige Inferenzen tragen dazu bei, dies zu ermöglichen.

Für jede Nachricht sind mehrere Schritte erforderlich. Bei der Erkennung von schädlichen Inhalten wären neben der Spracherkennung und Übersetzung für jede Nachricht mehrere Hin- und Rückläufe zum Server erforderlich. Durch die Ausführung dieser Aufgaben auf Clientseite konnte Policybazaar die prognostizierten Funktionskosten erheblich begrenzen.

Policybazaar hat von WebGL zu einem WebGPU-Backend (für unterstützte Browser) gewechselt und die Inferenzzeit hat sich um das Zehnfache verbessert. Nutzer erhielten schneller Feedback, um ihre Nachricht zu überarbeiten. Das führte zu mehr Interaktionen und höherer Kundenzufriedenheit.

// Create an instance of the toxicity model.

const createToxicityModelInstance = async () => {

try {

//use WebGPU backend if available

if (navigator.gpu) {

await window.tf.setBackend('webgpu');

await window.tf.ready();

}

return await window.toxicity.load(0.9).then(model => {

return model;

}).catch(error => {

console.log(error);

return null;

});

} catch (er) {

console.error(er);

}

}

Hohe Interaktions- und Klickrate

Durch die Kombination mehrerer Modelle mit Web-APIs konnte Policybazaar die Kundenbetreuung außerhalb der Geschäftszeiten ausweiten. Erste Ergebnisse aus einer begrenzten Einführung dieser Funktion haben ein hohes Nutzer-Engagement gezeigt.

73% der Nutzer, die den Chatbot geöffnet haben, führten Unterhaltungen mit mehreren Fragen, die mehrere Minuten dauerten. Dies führte zu einer niedrigen Ausstiegsrate. Außerdem wurde im Rahmen des Pilotprogramms eine doppelt so hohe Klickrate für diesen neuen Call-to-Action für die Kundenbetreuung verzeichnet, was auf eine erfolgreiche Kundeninteraktion mit Finova bei ihren Anfragen hindeutet. Außerdem wurde durch die Umstellung auf ein WebGPU-Backend für die clientseitige Erkennung von schädlichen Inhalten die Inferenz um das Zehnfache beschleunigt, was zu einem schnelleren Nutzerfeedback führte.

73 %

Nutzer haben hochwertige Unterhaltungen gestartet und daran teilgenommen

2-mal

Höhere Klickrate im Vergleich zum vorherigen Call-to-Action

10x

Schnellere Inferenz mit WebGPU

Ressourcen

Wenn Sie die Funktionen Ihrer eigenen Webanwendung mit clientseitiger KI erweitern möchten, gehen Sie so vor:

- Weitere Informationen zur Implementierung der clientseitigen Erkennung von schädlichen Inhalten

- Demos für clientseitige KI

- Weitere Informationen zu Mediapipe und Transformers.js Sie können mit vortrainierten Modellen arbeiten und sie mit JavaScript in Ihre Anwendung einbinden.

- Die KI-Sammlung in Chrome für Entwickler bietet Ressourcen, Best Practices und Neuigkeiten zu den Technologien, die KI in Chrome und darüber hinaus ermöglichen.

- Dazu gehört die Fallstudie dazu, wie Policybazaar und JioHotstar die Translator API und die Language Detection API verwenden, um mehrsprachige Inhalte zu erstellen.

- Reelle Beispiele für Web-KI auf der I/O 2025