Veröffentlicht: 10. November 2025

Nachdem Sie sich über angemessene KI informiert haben, wissen Sie, dass kleinere Modelle nachhaltiger sind als Foundation Models. Sie verbrauchen weniger Energie und können sogar auf dem Gerät des Nutzers ausgeführt werden, was die Latenz verringert und die Leistung verbessert.

Sie müssen bewusst vorgehen und das richtige Modell für Ihren Anwendungsfall auswählen.

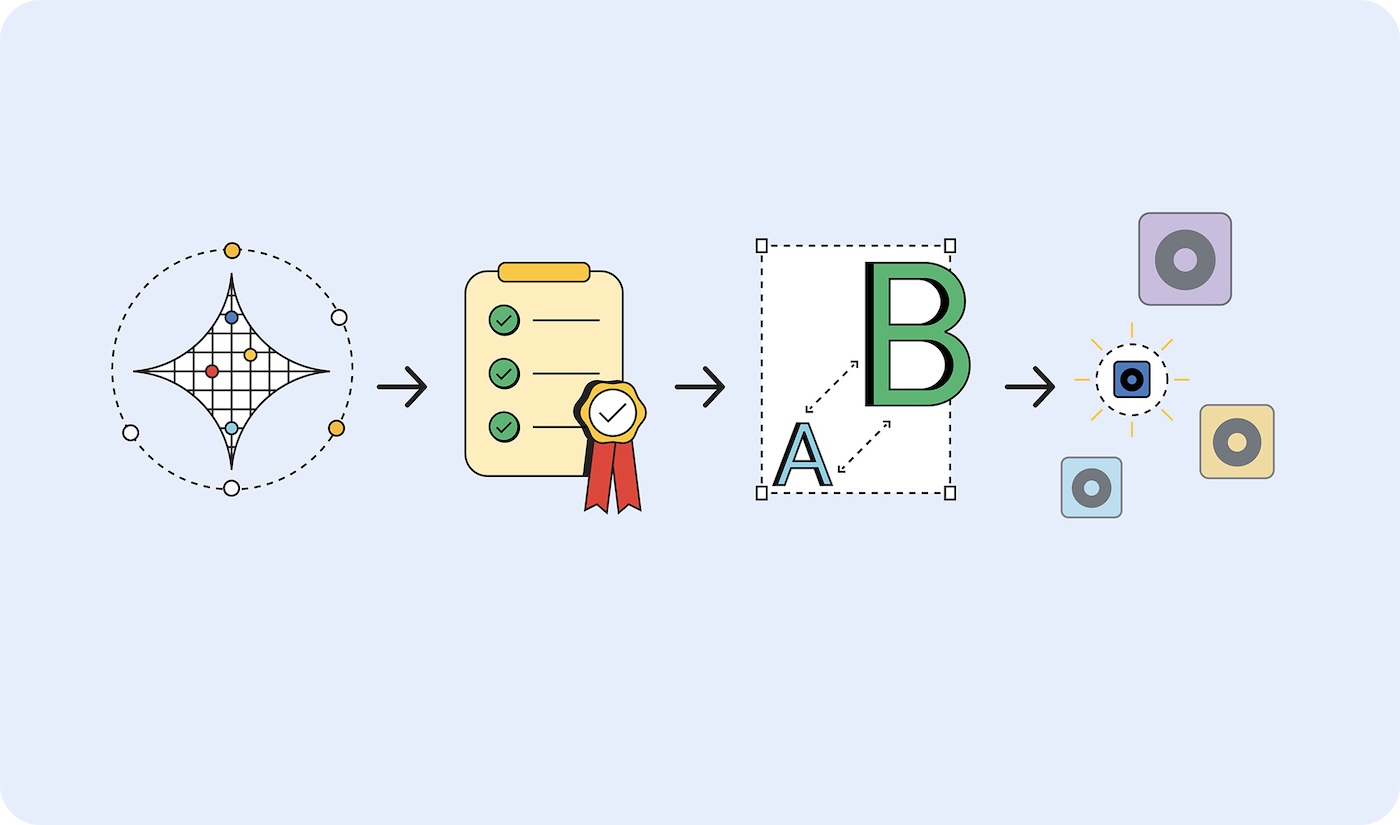

Aber wie finden Sie heraus, welches Modell Sie benötigen? Ein Ansatz besteht darin, die Erfolgsmesswerte für Ihre Anwendung zu bestimmen und dann einen Prototyp mit einem Foundation Model zu erstellen. In letzter Zeit waren viele der Foundation Models in den Nachrichten Large Language Models (LLMs). Foundation Models umfassen aber auch Predictive AI, die spezialisiert sind und möglicherweise besser für Ihren Anwendungsfall geeignet sind.

Nachdem Sie die Erfolgsmesswerte validiert haben, stellen Sie kleinere Modelle bereit und führen Sie Tests durch, bis Sie das kleinste Modell gefunden haben, das Ergebnisse liefert, die Ihren Erfolgskriterien entsprechen.

Große Prototypen erstellen, kleine Projekte bereitstellen

So wählen Sie das richtige Modell aus:

- Nachweisen, dass die Aufgabe möglich ist: Testen Sie mit dem größtmöglichen Modell, ob das, was Sie erreichen möchten, überhaupt möglich ist. Das kann ein großes Sprachmodell wie Gemini 2.5 Pro oder ein anderes Foundation Model sein.

- Erfolgskriterien festlegen: Sammeln Sie eine Reihe von Eingaben und idealen Ausgaben. Eine Übersetzungsanwendung kann beispielsweise Eingaben von Sätzen auf Englisch und Ausgaben dieser Sätze haben, die korrekt ins Spanische übersetzt wurden.

- Von klein nach groß testen: Vergleichen Sie die Ausgaben kleinerer Modelle mit Ihren Testkriterien. Beginnen Sie mit dem kleinsten Modell. Mit Prompt-Engineering können Sie bessere Ergebnisse erzielen. Sie können auch ein größeres Modell einsetzen, um die Ausgaben zu vergleichen und so ein besseres Ergebnis mit Ihrem kleineren Modell zu erzielen.

- Wählen Sie das kleinste Modell aus, das für Ihren Anwendungsfall akzeptable Antworten liefert. Das kleinste Modell, das Übersetzungen korrekt ausgibt.

Unabhängig davon, wo das Modell gehostet wird, ist es effizienter, ein kleineres als ein größeres Modell zu verwenden, wenn es klein genug ist, um auf dem Gerät ausgeführt zu werden, oder wenn es auf einem Server gehostet werden muss.

Modelltypen

Ich habe die Modelle nach den Daten kategorisiert, die sie verarbeiten: visuell, Audio und Text. Ich zeige Ihnen einige Anwendungsbeispiele und die verfügbaren Modelle.

Visuelle Verarbeitung

Die visuelle Verarbeitung kann die Auswertung von Standbildern oder Videos umfassen.

Bildklassifizierung: Diese Funktion kann für alles verwendet werden, von der Generierung von Alt-Text für die Einhaltung der Barrierefreiheit bis hin zur Inhaltsprüfung, um unangemessene Bilder zu filtern, bevor sie Nutzer erreichen. Wählen Sie diese Bildklassifizierung aus, wenn Sie wissen möchten, was auf einem Bild zu sehen ist, ohne dass eine manuelle Überprüfung erforderlich ist.

Modelle: MobileNet, ResNeXt und ConvNeXt

Objekterkennung: Bestimmte Objekte in Bildern oder Videostreams taggen, interaktive AR-Erlebnisse erstellen, die auf reale Objekte reagieren, oder Bestandsverwaltungssysteme entwickeln, die Artikel identifizieren und zählen können. Wählen Sie die Objekterkennung aus, wenn Sie ein Bild oder Video von einem unbelebten Objekt haben.

Modelle: Objekterkennungsmodelle wie YOLOv8 und DETR

Erkennung von Körperhaltungen: Kann für die Steuerung der Benutzeroberfläche mit Gesten oder Körperbewegungen, für virtuelle Anproben von Kleidung und für Telemedizinplattformen verwendet werden, auf denen Patientenbewegungen und Fortschritte bei der Rehabilitation überwacht werden. Wählen Sie die Erkennung von Körperhaltungen aus, wenn Sie Bilder oder Videos vom Körper einer Person bewerten.

Modelle: Modelle zur Schätzung der Körperhaltung, z. B. MoveNet und BlazePose

Gesichts-Keypoint-Erkennung: Wird für sichere Systeme zur Gesichtserkennung, zur Erkennung von Emotionen zur Personalisierung der Nutzererfahrung, zur Verfolgung von Augenbewegungen für barrierefreie Steuerelemente und für Echtzeit-Fotofilter oder Beauty-Apps verwendet. Wählen Sie dieses Modell aus, wenn Sie Bilder oder Videos vom Gesicht einer Person bewerten.

Modelle MediaPipe FaceMesh und OpenPose

Modelle zur Erkennung von Handposen: Diese Modelle eignen sich für berührungslose Schnittstellen, bei denen Nutzer mit Handbewegungen navigieren, für Anwendungen zur Übersetzung von Gebärdensprache für Menschen mit Behinderungen und für kreative Tools, die auf Handbewegungen reagieren, um zu zeichnen oder zu gestalten. Erwägen Sie auch, sie in Umgebungen zu verwenden, in denen die Berührung von Bildschirmen unpraktisch ist (z. B. in der Medizin oder im Gastgewerbe), oder wenn Nutzer weit von den Steuerelementen entfernt sind, z. B. bei Präsentationen, bei denen Referenten Folien mit Gesten steuern.

Modelle: Modelle zur Schätzung der Handhaltung, z. B. MediaPipe Hands.

Handschrifterkennung: Wird verwendet, um handschriftliche Notizen in durchsuchbaren digitalen Text umzuwandeln, Eingaben mit dem Eingabestift für Notizen-Apps zu verarbeiten und von Nutzern hochgeladene Formulare oder Dokumente zu digitalisieren.

Modelle: Modelle für die optische Zeichenerkennung (OCR) wie MiniCPM-o, H2OVL-Mississippi und Surya.

Bildsegmentierungsmodelle: Wählen Sie diese aus, wenn einheitliche Bildhintergründe wichtig sind oder eine Bildbearbeitung erforderlich ist. Sie können sie beispielsweise für das präzise Entfernen von Hintergründen, die erweiterte Inhaltsprüfung zur Identifizierung bestimmter Problembereiche in Bildern und anspruchsvolle Fotobearbeitungstools zum Isolieren bestimmter Elemente wie Profil- und Produktfotos verwenden.

Modelle: Segment Anything (SAM), Mask R-CNN

Bildgenerierung: Mit dieser Funktion können Sie bei Bedarf neue Bilder ohne Lizenzierung erstellen. Diese Modelle können verwendet werden, um personalisierte Avatare für Nutzerprofile, Produktbildvarianten für E-Commerce-Kataloge und benutzerdefinierte Grafiken für Marketing- oder Content-Erstellungsworkflows zu erstellen.

Modelle: Diffusion-Modelle wie Nano Banana, Flux und Qwen Image

Audioverarbeitung

Wählen Sie ein Modell für die Audioverarbeitung für Audiodateien aus.

Audio-Klassifizierung: Verwenden Sie diese Option, wenn Audioinhalte ohne manuelle Überprüfung identifiziert und beschrieben werden müssen. Dazu gehören beispielsweise die Echtzeit-Identifizierung von Hintergrundmusik, Umgebungsgeräuschen oder gesprochenen Inhalten in Media-Uploads, die automatische Inhaltskennzeichnung für Audiobibliotheken und soundbasierte Benutzeroberflächen-Steuerelemente.

Modelle: Wav2Vec2 und AudioMAE

Audio generieren: Sie können Audioinhalte bei Bedarf ohne Lizenzierung erstellen. So können beispielsweise benutzerdefinierte Soundeffekte für interaktive Weboberflächen erstellt, Hintergrundmusik auf Grundlage von Nutzerpräferenzen oder ‑inhalten generiert und Audio-Branding-Elemente wie Benachrichtigungstöne oder Feedback für die Benutzeroberfläche produziert werden.

Modelle: Es gibt verschiedene spezialisierte Modelle für die Audiogenerierung. Diese sind in der Regel sehr spezifisch, daher werde ich keine Modelle auflisten.

Sprachausgabe (Text-to-Speech, TTS): Wandeln Sie geschriebene Inhalte in eine einheitliche, natürlich klingende Sprache um, um die Anforderungen an die Barrierefreiheit zu erfüllen, Voiceover für Lerninhalte oder Tutorials zu erstellen und mehrsprachige Benutzeroberflächen zu entwickeln, die Text in der bevorzugten Sprache der Nutzer ausgeben.

Modelle Orpheus und Sesame CSM

Speech-to-Text (STT): Transkribieren Sie eine Aufnahme menschlicher Sprache, z. B. für die Echtzeit-Transkription bei Live-Events oder Meetings, die sprachgesteuerte Navigation und Suche sowie die automatische Untertitelung von Videoinhalten zur Barrierefreiheit.

Modelle Whisper Web Turbo, NVIDIA Canary und Kyutai

Textverarbeitung

Klassifizierung in natürlicher Sprache (NLP): Damit lassen sich große Mengen an Text, Tagging-Systeme und Moderationssysteme automatisch sortieren und weiterleiten. Der Text kann aus Nutzernachrichten oder Support-Tickets stammen, die Stimmung in Kundenfeedback oder Erwähnungen in sozialen Medien erkennen und Spam oder unangemessene Inhalte filtern, bevor sie andere Nutzer erreichen.

Modelle BERT, DistilBERT und RoBERTa

Konversationelle KI: Chat-Oberflächen und Konversationssysteme erstellen. Chatbots für den Kundensupport, persönliche KI-Assistenten und ähnliche konversationelle Interaktionen sind einige der besten Anwendungsfälle für LLMs. Glücklicherweise gibt es Sprachmodelle, die klein genug sind, um auf Ihr Gerät zu passen, und die viel weniger Energie für das Training und die Eingabeaufforderung benötigen.

Modelle: Gemma 2 27B, Llama 3.1 und Qwen2.5

Übersetzungsmodelle: Damit können Sie mehrere Sprachen in Ihrer Anwendung unterstützen. Lokale Sprachmodelle können Sprachübersetzungen in Echtzeit vornehmen, nutzergenerierte Inhalte für globale Plattformen in mehrere Sprachen konvertieren und private Dokumentübersetzungen ermöglichen, bei denen vertrauliche Inhalte auf dem Gerät des Nutzers verbleiben.

Modelle: SLMs wie Gemma Nano, Granite 1.5B, GSmolLM3 und Qwen 3.4B

Nährwertkennzeichnung lesen

Je nach Modell, Hardware und Standort werden unterschiedliche Mengen dieser Ressourcen verbraucht. Es gibt noch keinen Standard für die Messung, an dem sich orientiert werden kann. Es gibt jedoch Bestrebungen, diese Informationen auf KI-„Nährwertkennzeichnungen“ zu veröffentlichen.

Modellkarten, die 2018 von Margaret Mitchell und ihren Kollegen bei Google eingeführt wurden, sind ein standardisierter Ansatz zur Berichterstellung über die vorgesehene Verwendung, Einschränkungen, ethische Überlegungen und Leistung von Modellen. Viele Unternehmen verwenden heute eine Form von Modellkarten, darunter Hugging Face, Meta und Microsoft.

AI-Faktenblätter von IBM, die sich mit Lebenszyklus, Verantwortlichkeit, Governance und Compliance befassen, sind in Unternehmensumgebungen beliebter. Regulierungsrahmen wie das EU-Gesetz zur künstlichen Intelligenz, das NIST AI Risk Management Framework und ISO 42001 erfordern diese Dokumentation.

Google hat Transparenz bei den Inferenzkosten in der gesamten Branche gefordert. Diese Zahlen könnten Modellkarten und Faktenblättern hinzugefügt werden. Hugging Face hat CO₂-Kosten in die Modellkarten aufgenommen und sich mit der AI Energy Score-Initiative um die Standardisierung der Energieeffizienzmessung bemüht.

Für die richtige KI eintreten

Die richtige KI-Größe ist die nachhaltige, leistungsstarke und pragmatische Wahl für Ihre Kunden und Ihr Unternehmen.

Sie können die Branche voranbringen, indem Sie von gehosteten Modellen, die Ihr Unternehmen verwendet, verlangen, dass sie ihre grundlegenden Anforderungen an Trainings- und Inferenzressourcen offenlegen. Wenn genügend Kunden Transparenz fordern, geben Anbieter diese Details mit höherer Wahrscheinlichkeit an.