發布日期:2025 年 11 月 10 日

閱讀適當大小的 AI 一文後,您會瞭解小型模型比基礎模型更具永續性。這類模型耗用的能源較少,甚至可以在使用者裝置上執行,減少延遲時間並提供效能更高的體驗。

您必須有明確目標,並根據用途選擇合適模型。

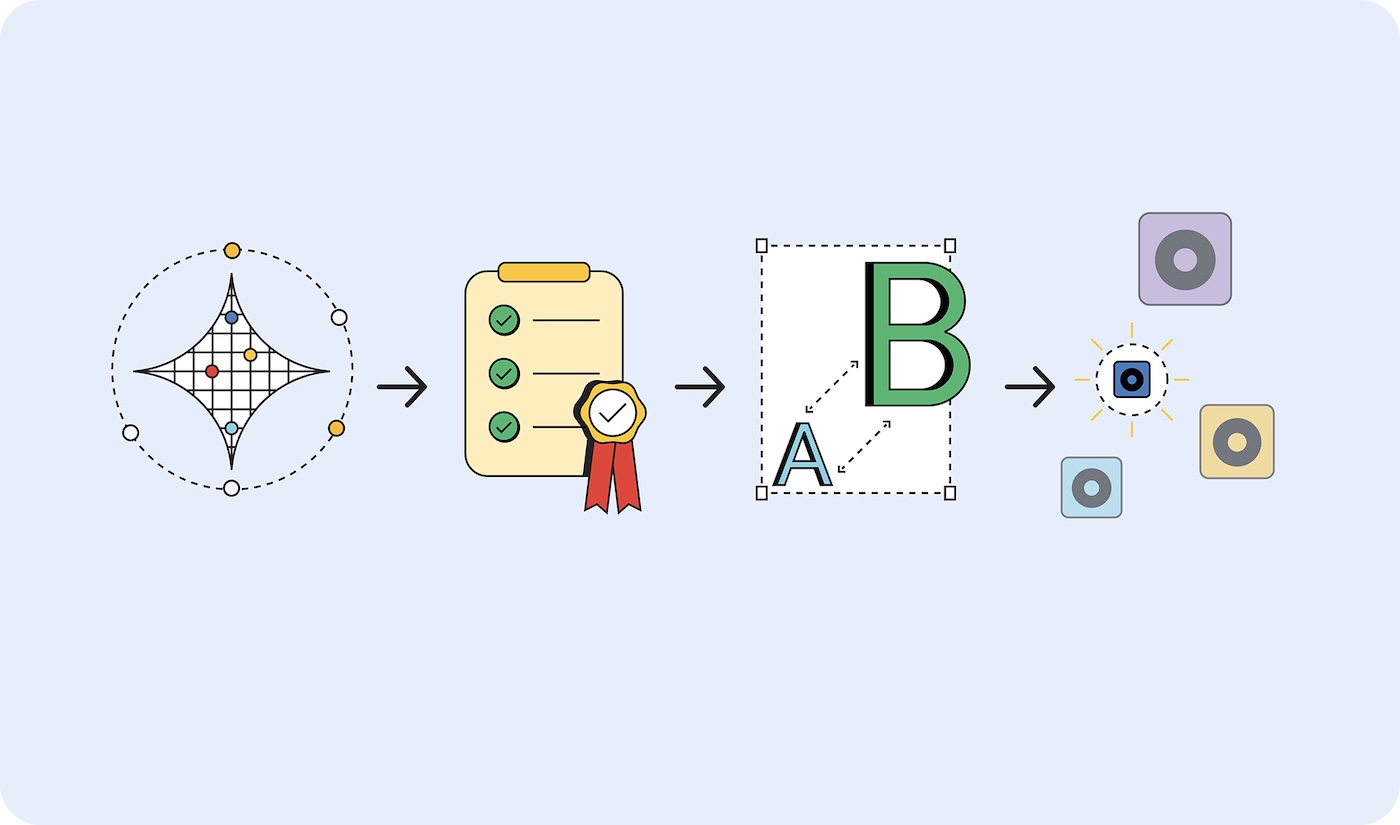

但如何判斷需要哪種模型?其中一種做法是先判斷應用程式的成效指標,然後使用基礎模型製作原型。雖然最近新聞報導中的許多基礎模型都是大型語言模型 (LLM),但基礎模型也包括預測型 AI,這類模型經過專業訓練,可能更適合您的用途。

驗證成功指標後,請使用較小的模型進行部署,並測試到找出最小的模型為止,確保模型產生的結果符合成功標準。

原型設計要大,部署要小

如要選擇合適大小的模型,請按照下列步驟操作:

- 證明任務可行。使用盡可能最大的模型,測試您嘗試完成的工作是否可行。可以是大型語言模型 (例如 Gemini 2.5 Pro),也可以是其他基礎模型。

- 設定成功標準。收集一組輸入內容和理想輸出內容。舉例來說,翻譯應用程式可能會輸入英文詞組,並輸出正確翻譯成西班牙文的詞組。

- 從小到大測試。根據測試條件比較較小模型的輸出內容。從最小的模型開始逐步升級。 提示工程可協助你取得更精確的結果。您也可以徵求較大型模型的輸出內容進行比較,協助您從較小型模型產生更優質的結果。

- 選取最小的模型,確保模型能針對您的用途提供可接受的回應。例如,輸出內容正確的最小模型。

無論模型是託管在裝置上還是伺服器上,使用較小的模型都比使用較大的模型更有效率。

模型類型

我已根據模型處理的資料將其分類:視覺、音訊和文字。我將逐步說明範例用途和一些可用的模型。

視覺處理

視覺處理可評估靜態圖片或影片。

圖片分類:可用於各種用途,包括產生替代文字以符合無障礙規範、篩選內容,以及在不當圖片顯示給使用者前加以過濾。如要瞭解圖片內容,但不需要人工審查,請選擇這項圖片分類。

模型:MobileNet、ResNeXt 和 ConvNeXt

物件偵測:標記圖片或影片串流中的特定物件、建立可回應實體物件的互動式 AR 體驗,或建構可識別及計算項目的庫存管理系統。如果圖片或影片中是無生命物體,請選取「物體偵測」。

模型:物件偵測模型,例如 YOLOv8 和 DETR

身體姿勢偵測:用於透過手勢或身體動作控制介面、提供服飾虛擬試穿體驗,以及在遠距醫療平台監控病患動作和復健進度。評估人體圖像或影片時,請選擇「偵測身體姿勢」。

模型:姿勢估測模型,例如 MoveNet 和 BlazePose

臉部特徵點偵測:用於安全臉部驗證系統、情緒偵測 (可提供個人化使用者體驗)、眼球移動追蹤 (可提供無障礙控制項),以及即時相片濾鏡或美顏應用程式。評估人臉圖片或影片時,請選取這個模型。

模型:MediaPipe FaceMesh 和 OpenPose

手部姿勢偵測模型:使用這些模型進行免觸控介面控制,讓使用者透過手勢操作、無障礙手語翻譯應用程式,以及可回應手部動作的繪圖或設計創意工具。此外,在不適合觸控螢幕的環境 (醫療、餐飲服務) 中,或使用者遠離控制項時 (例如演講者以手勢控制投影片),也建議使用這項功能。

模型:手部姿勢估算模型,例如 MediaPipe Hands。

手寫辨識:將手寫筆記轉換為可搜尋的數位文字、處理筆記應用程式的觸控筆輸入內容,以及將使用者上傳的表單或文件數位化。

模型:光學字元辨識 (OCR) 模型,例如 MiniCPM-o、H2OVL-Mississippi 和 Surya。

圖片分割模型:如果圖片背景必須一致,或需要編輯圖片,請選擇這個模型。舉例來說,您可以精確移除背景、使用進階內容篩選功能找出圖片中特定問題區域,以及使用進階相片編輯工具分離特定元素,例如個人資料和產品相片。

模型:Segment Anything (SAM)、Mask R-CNN

生成圖片:隨時建立新圖片,無需授權。 這些模型可用於建立使用者個人資料的個人化顯示圖片、電子商務目錄的產品圖片變化版本,以及行銷或內容建立工作流程的自訂圖像。

模型:擴散模型,例如 Nano Banana、Flux 和 Qwen Image

音訊處理

為音訊檔案選擇音訊處理模型。

音訊分類:用於識別及描述音訊,無須專人審查。例如即時辨識媒體上傳內容中的背景音樂、環境音效或語音內容、自動為音訊資料庫加上內容標記,以及透過聲音控制使用者介面。

模型:Wav2Vec2 和 AudioMAE

生成音訊:隨選生成音訊內容,不必取得授權。舉例來說,這項技術可用於為互動式網頁體驗建立自訂音效、根據使用者偏好或內容生成背景音樂,以及製作通知音效或介面回饋等音訊品牌元素。

模型:有各種專門的音訊生成模型。這些模型通常非常具體,因此我不會列出模型。

文字轉語音 (TTS):將書面內容轉換為一致且自然流暢的語音,以符合無障礙規範、為教育內容或教學課程建立旁白,以及建構以使用者偏好語言朗讀文字的多語言介面。

模型:Orpheus 和 Sesame CSM

語音轉文字 (STT):轉錄人類語音的錄音內容,例如即時轉錄現場活動或會議內容、語音控制的導覽和搜尋功能,以及自動為影片內容產生字幕,提升無障礙體驗。

模型:Whisper Web Turbo、NVIDIA Canary 和 Kyutai

文字處理

自然語言分類 (NLP):用於自動分類及傳送大量文字、標記系統和內容審查系統。例如使用者訊息或支援單、偵測顧客意見回饋或社群媒體提及內容中的情緒、在垃圾內容或不當內容傳送給其他使用者前進行篩選。

模型:BERT、DistilBERT 和 RoBERTa

對話式 AI:建構對話介面和對話系統。 客戶服務聊天機器人、個人 AI 助理和類似的對話式互動,都是 LLM 的最佳應用案例。幸好,有些語言模型夠小,可裝入裝置,訓練和提示所需的能源也少得多。

模型:Gemma 2 27B、Llama 3.1 和 Qwen2.5

翻譯模型:用於支援應用程式中的多種語言。本機語言模型可處理即時語言翻譯,將全球平台上的多種語言使用者生成內容轉換為其他語言,並支援私人文件翻譯,確保敏感內容留在使用者裝置上。

模型:Gemma Nano、Granite 1.5B、GSmolLM3 和 Qwen 3.4B 等 SLM

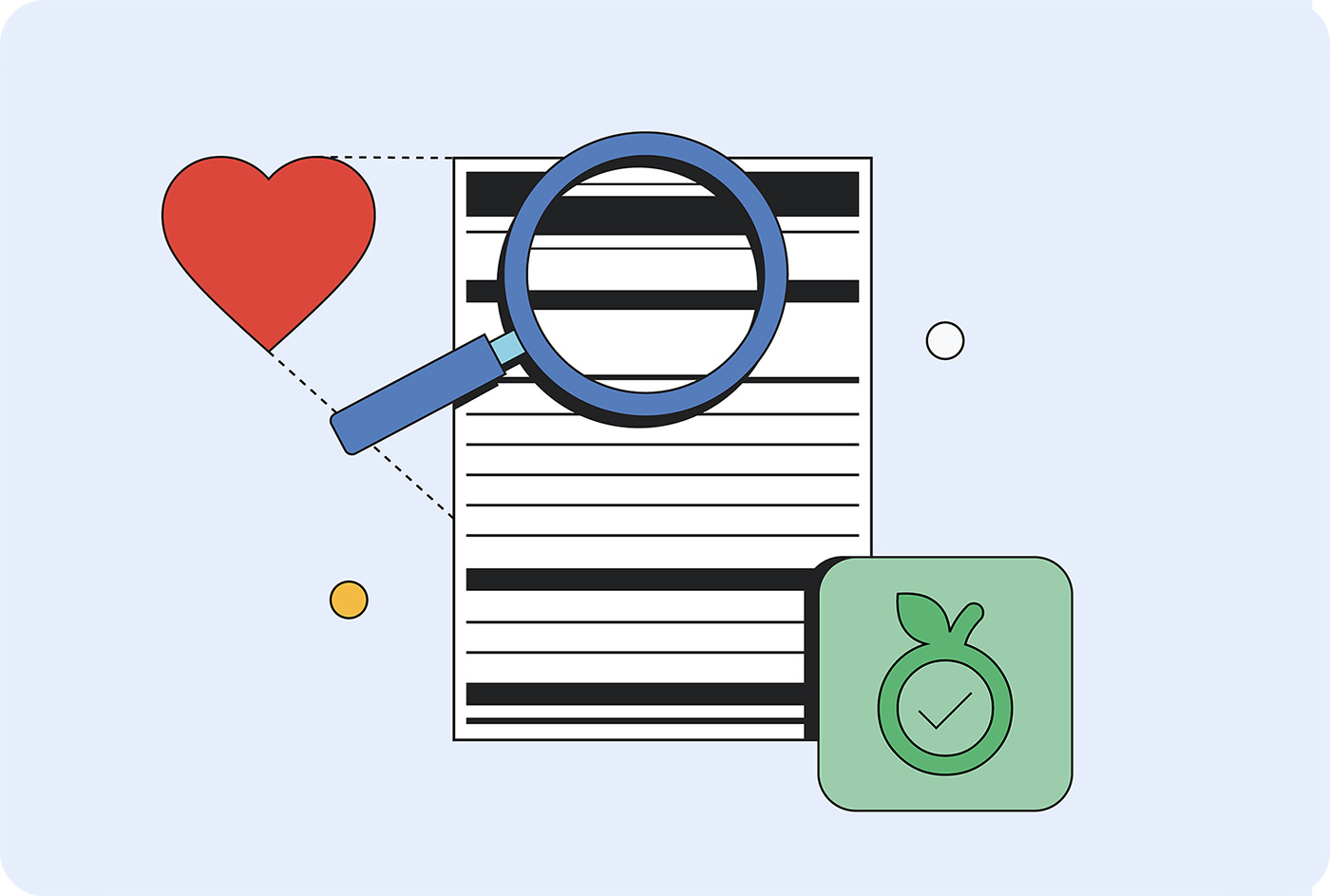

閱讀營養標籤

在不同位置的不同硬體上執行時,不同模型會消耗不同數量的這些資源。目前還沒有可供比較的標準,但有趨勢顯示這類資訊會出現在 AI「營養標籤」上。

模型資訊卡是 Margaret Mitchell 和 Google 同事於 2018 年提出的標準化做法,用於報告模型的預期用途、限制、倫理考量和效能。目前許多公司都使用某種形式的模型資訊卡,包括 Hugging Face、Meta 和 Microsoft。

IBM 的 AI 資訊表涵蓋生命週期、問責、控管和法規遵循,在企業環境中更受歡迎。《歐盟 AI 法案》、NIST AI 風險管理架構和 ISO 42001 等監管架構都要求提供這類文件。

Google 呼籲業界提高推論成本透明度。 這些數據可能會新增至模型資訊卡和事實表。Hugging Face 已在模型資訊卡中加入碳排放成本,並致力於透過 AI 能源分數計畫,將能源效率評估標準化。

提倡適當規模的 AI

適當規模的 AI 是永續、高效且實用的選擇,可為顧客和貴商家帶來助益。

您可以要求公司採用的代管模型揭露基準訓練和推論資源需求,進而推動產業發展。如果足夠多的消費者要求透明度,供應商就更有可能發布這些詳細資料。