发布时间:2025 年 11 月 10 日

阅读适量 AI 后,您会知道,与基础模型相比,小型模型更具可持续性。它们能耗更低,甚至可以在用户设备上运行,从而缩短延迟时间并提供更出色的性能体验。

您必须有明确的目标,并根据自己的应用场景选择合适的模型。

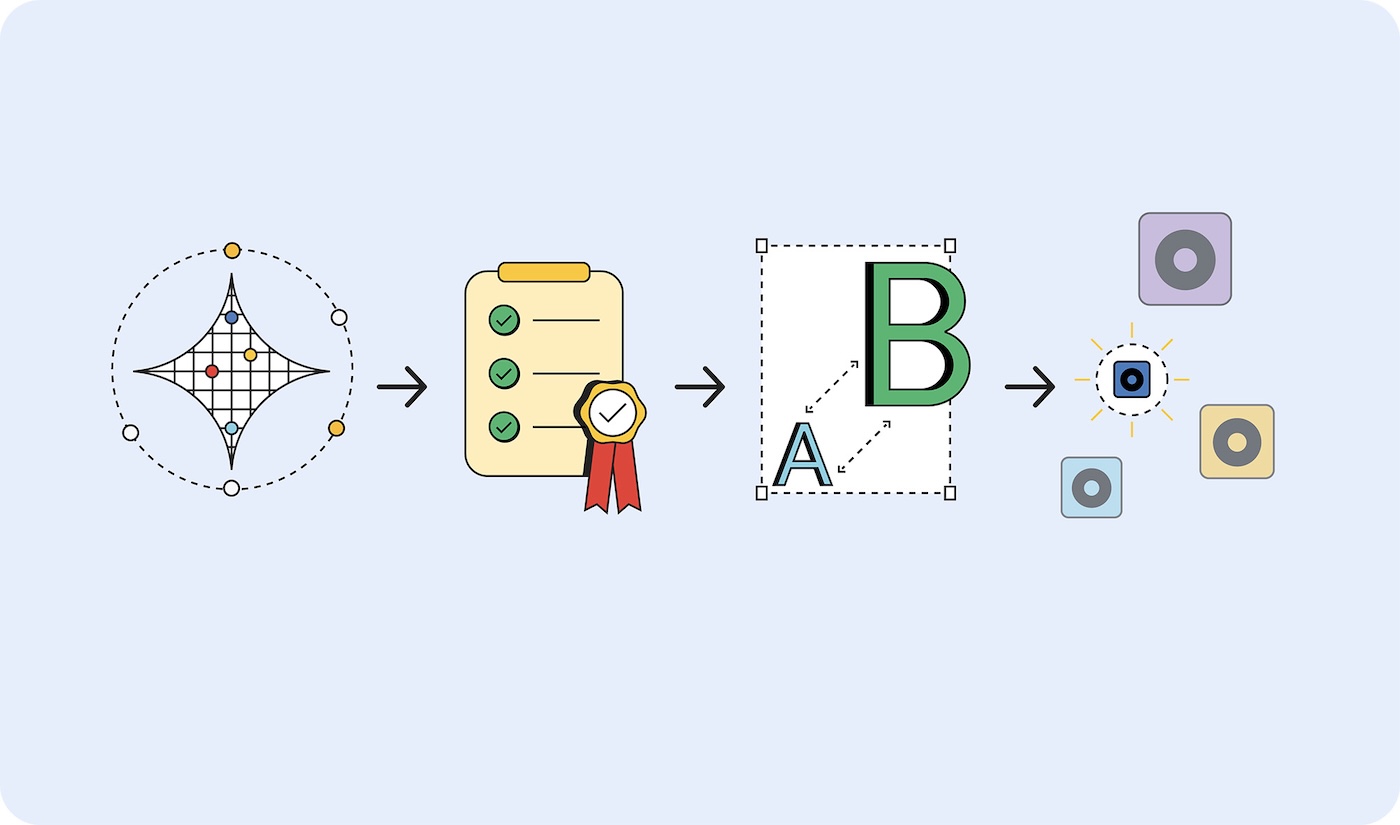

但如何确定您需要哪种模型?一种方法是先确定应用的成功指标,然后使用基础模型进行原型设计。虽然最近新闻中的许多基础模型都是大语言模型 (LLM),但基础模型也包括预测性 AI,后者经过专门训练,可能更适合您的使用情形。

验证成功指标后,部署较小的模型,并进行测试,直到找到能产生符合成功标准的结果的最小模型。

原型设计大,部署小

如需选择合适的模型,请按以下步骤操作:

- 证明您的任务是可行的。使用尽可能大的模型测试您尝试完成的任务是否可行。这可以是 Gemini 2.5 Pro 等大语言模型,也可以是其他基础模型。

- 设置成功标准。收集一组输入和理想输出。例如,一个翻译应用可能以英语短语作为输入,并以正确翻译成西班牙语的相应短语作为输出。

- 从小到大进行测试。将较小模型的输出与测试标准进行比较。从最小的模型开始,逐步增大模型规模。 提示工程有助于您获得更好的结果。您还可以招募一个更大的模型来比较输出,以帮助您从较小的模型中获得更好的结果。

- 选择能为您的应用场景提供可接受回答的最小模型。例如,能够正确输出翻译结果的最小模型。

无论模型托管在何处,如果模型足够小,可以放在设备上,或者仍需要托管在服务器上,使用较小的模型都比使用较大的模型更高效。

模型类型

我已按模型处理的数据类型(视觉、音频和文本)对模型进行了分类。我将介绍一些示例用例和一些可用的模型。

视觉处理

视觉处理可以是对静态图片或视频的评估。

图片分类:可用于各种用途,从生成符合无障碍标准的替代文本,到内容筛查,再到在不当图片到达用户之前将其过滤掉。如果您需要了解图片中的内容,但不想进行人工审核,请选择此图片分类。

模型 MobileNet、ResNeXt 和 ConvNeXt

对象检测:标记图片或视频流中的特定对象,创建可响应现实世界对象的互动式 AR 体验,或构建可识别和统计商品的库存管理系统。如果您有无生命物体的图片或视频,请选择“物体检测”。

模型:对象检测模型,例如 YOLOv8 和 DETR

身体姿势检测:用于通过手势或身体动作控制界面、提供服装虚拟试穿体验,以及在远程医疗平台上监控患者的活动和康复进度。在评估人体图像或视频时,请选择人体姿态检测。

模型:姿态估计模型,例如 MoveNet 和 BlazePose

面部关键点检测:用于安全的面部身份验证系统、用于个性化用户体验的情绪检测、用于辅助控制的眼球运动追踪,以及实时照片滤镜或美颜应用。 在评估人脸图像或视频时,请选择此模型。

模型 MediaPipe FaceMesh 和 OpenPose

手部姿势检测模型:使用这些模型可实现免触界面控制,让用户通过手势导航;还可用于手语翻译应用,以提高无障碍性;以及用于创意工具,让工具根据手部动作进行绘画或设计。此外,在触摸屏幕不切实际的环境(医疗、餐饮服务)中,或者当用户远离控制设备时(例如演示者通过手势控制幻灯片的演示),也可以考虑使用这些功能。

模型:手部姿势估计模型,例如 MediaPipe Hands。

手写识别:用于将手写笔记转换为可搜索的数字文本、处理记事应用的触控笔输入内容,以及将用户上传的表单或文档数字化。

模型:光学字符识别 (OCR) 模型,例如 MiniCPM-o、H2OVL-Mississippi 和 Surya。

图片分割模型:当需要保持图片背景一致或需要进行图片修改时,请选择此模型。例如,您可以使用这些模型精确移除背景、进行高级内容筛查以识别图片中的特定问题区域,以及使用复杂的照片编辑工具来隔离特定元素,例如个人资料照片和产品照片。

模型:Segment Anything (SAM)、Mask R-CNN

图片生成:用于按需创建新图片,无需许可。 这些模型可用于为用户个人资料创建个性化头像、为电子商务目录创建产品图片变体,以及为营销或内容创作工作流程创建自定义视觉效果。

模型:扩散模型,例如 Nano Banana、Flux 和 Qwen Image

音频处理

为音频文件选择音频处理模型。

音频分类:在需要识别和描述音频但无需人工审核的情况下使用。例如,实时识别媒体上传内容中的背景音乐、环境声音或语音内容;自动为音频库添加内容标记;以及基于声音的用户界面控制。

模型:Wav2Vec2 和 AudioMAE

音频生成:无需获得许可即可按需创建音频内容。例如,它可以用于为互动式 Web 体验创建自定义音效、根据用户偏好或内容生成背景音乐,以及制作音频品牌元素(例如通知声音或界面反馈)。

模型 有多种专业音频生成模型。这些问题往往非常具体,因此我不会列出型号。

文字转语音 (TTS):将书面内容转换为自然流畅的语音,以符合无障碍要求;为教育内容或教程创建旁白;以及构建可使用用户偏好的语言朗读文本的多语言界面。

型号 Orpheus 和 Sesame CSM

语音转文字 (STT):转写人类语音的录音,例如用于实时转写现场活动或会议、语音控制的导航和搜索功能,以及为视频内容提供自动字幕,以提高无障碍性。

模型 Whisper Web Turbo、NVIDIA Canary 和 Kyutai

文本处理

自然语言分类 (NLP):用于自动对大量文本、标记系统和审核系统进行排序和路由。文本可以是用户消息或支持服务工单,用于检测客户反馈或社交媒体提及内容中的情感,以及在垃圾内容或不当内容到达其他用户之前对其进行过滤。

模型:BERT、DistilBERT 和 RoBERTa

对话式 AI:构建聊天界面和对话式系统。 客服聊天机器人、个人 AI 助理和类似的对话式互动是 LLM 的最佳应用场景。幸运的是,有一些语言模型足够小,可以安装在设备上,并且训练和提示所需的能耗要少得多。

模型:Gemma 2 27B、Llama 3.1 和 Qwen2.5

翻译模型:用于在应用中支持多种语言。 本地语言模型可以处理实时语言翻译,将用户生成的内容在多种语言之间进行转换,以供全球平台使用,并支持私密文档翻译,将敏感内容保留在用户的设备上。

模型:Gemma Nano、Granite 1.5B、GSmolLM3 和 Qwen 3.4B 等 SLM

读取营养成分标签

在不同位置的不同硬件上运行时,不同模型会消耗不同数量的这些资源。目前还没有可供参考的衡量标准,但我们正在努力将这些信息添加到 AI“营养标签”中。

模型卡片是 Margaret Mitchell 和 Google 的同事于 2018 年推出的一种标准化方法,用于报告模型的预期用途、局限性、道德层面的考虑因素和性能。如今,许多公司都在使用某种形式的模型卡片,包括 Hugging Face、Meta 和 Microsoft。

IBM 的 AI Factsheets 涵盖生命周期、问责制、治理、合规性,在企业环境中更受欢迎。欧盟《AI 法案》、NIST AI 风险管理框架和 ISO 42001 等监管框架都要求提供此文档。

Google 呼吁提高整个行业的推理成本透明度。 这些数据可以添加到模型卡片和概况介绍中。Hugging Face 已在其模型卡片中添加了碳排放成本,并努力通过 AI 能源得分计划来标准化能效衡量。

倡导使用适合规模的 AI

适度 AI 是客户和企业的可持续、高性能且实用的选择。

您可以要求公司采用的托管模型披露其基准训练和推理资源要求,从而推动行业发展。如果足够多的客户要求透明度,提供商就更有可能发布这些详细信息。